YouTube s'associe à Wikipédia contre les conspirationnistes

Les vidéos conspirationnistes n’en finissent plus de fleurir sur YouTube. Pour démonter ces théories du complot et pallier la désinformation qui ne cesse de se développer notamment autour des dernières fusillades en Floride, YouTube se tourne vers un allié inattendu, Wikipédia. Les vidéos proposeront bientôt des liens vers des pages de l’encyclopédie en ligne pour contrecarrer les rumeurs…

Le 14/03/2018 à 14:33 par Fasseur Barbara

0 Réactions | 0 Partages

Publié le :

14/03/2018 à 14:33

0

Commentaires

0

Partages

La plateforme a choisi de retirer la vidéo de son site, mais elle avait déjà atteint les quelques 200 000 vues… Afin d’éviter que ce genre d’engouement autour de fausses informations ne se reproduise, la société s’est décidée à agir. Le site Wired précise cependant que YouTube n’en a pas dit plus sur la manière dont il prévoit de gérer la diffusion de ce genre de vidéo de désinformation.

Hier, la directrice générale du site, Susan Wojcicki, a cependant présenté une solution potentielle. Elle annonce ainsi que YouTube ajoutera dorénavant aux vidéos conspirationnistes des liens vers des contenus avec une approche plus factuelle. Wojcicki a apporté des précisions sur cette nouvelle fonctionnalité qu’elle nomme « indicateurs d’information » à l’éditeur en chef du site Wired, Nicholas Thompson, lors de la conférence South by Southwest à Austin, le 14 mars.

Il rapporte ainsi le fonctionnement : « Si vous recherchez et cliquez sur une vidéo conspirationniste à propos, disons, des chemtrails [De l'anglais chemical trails, traînées chimiques, ndlr] déversées par les avions à haute altitude, YouTube vous proposera dorénavant un lien vers une page Wikipédia qui démonte les canulars liés à la vidéo. Un autre exemple : une vidéo qui remet en cause le fait que l’être humain n’ait jamais posé le pied sur la lune pourrait être accompagnée par la page Wikipédia officielle à propos de l’alunissage du programme Apollo en 1969. »

Every single video on the YouTube trending page is fake. The videos are made by 'verified' YouTube creators, they garner millions of views and the sad reality is that Google is indirectly encouraging the promotion of hoax content with AdSense dollars. pic.twitter.com/EepDCylP6y

— Amit Agarwal (@labnol) 1 mars 2018

Soit : « Chacune des vidéos sur la page des tops de Youtube sont fausses. Les vidéos sont réalisées par des créateurs youtube "vérifiés", ils récoltent des millions de vues et la triste réalité, c'est que Google encourage indirectement la promotion de canulars avec les dollars d'AdSense [Régie publicitaire de Google, ndlr.] » Les revenus liés aux Google Ads sont en effet importants, et ces vidéos particulièrement plébiscitées. CQFD...

À plusieurs reprises, l'algorithme de YouTube a d'ailleurs été pointé pour ses résultats de recherches orientés... vers des vidéos problématiques. Par ailleurs, Wikipedia reste une encyclopédie en accès libre, en lecture comme en écriture : sa fiabilité dépend de l'activité des modérateurs, et de leur propre légitimité. Le site a d'ailleurs lui-même dû revoir ses politiques de vérification et de relecture, pour éviter la propagation de fausses informations...

Plus d'articles sur le même thème

Ils se revendiquent d'Apostrophes ou Radioscopie : Les Inactuels

Collectif de journalistes culturels, Les Inactuels revendiquent exigence et liberté de ton — une indépendance éditoriale, pour des émissions ancrées dans une histoire. Parce que celles qui les ont marquées ont disparu, voilà une trentaine d’années, ils reprennent le flambeau, à leur manière. Et sollicitent l'aide des internautes pour ce faire.

24/03/2024, 17:39

Fureur, sauvagerie : qu'est-ce que l'homme face à l'immense nature ?

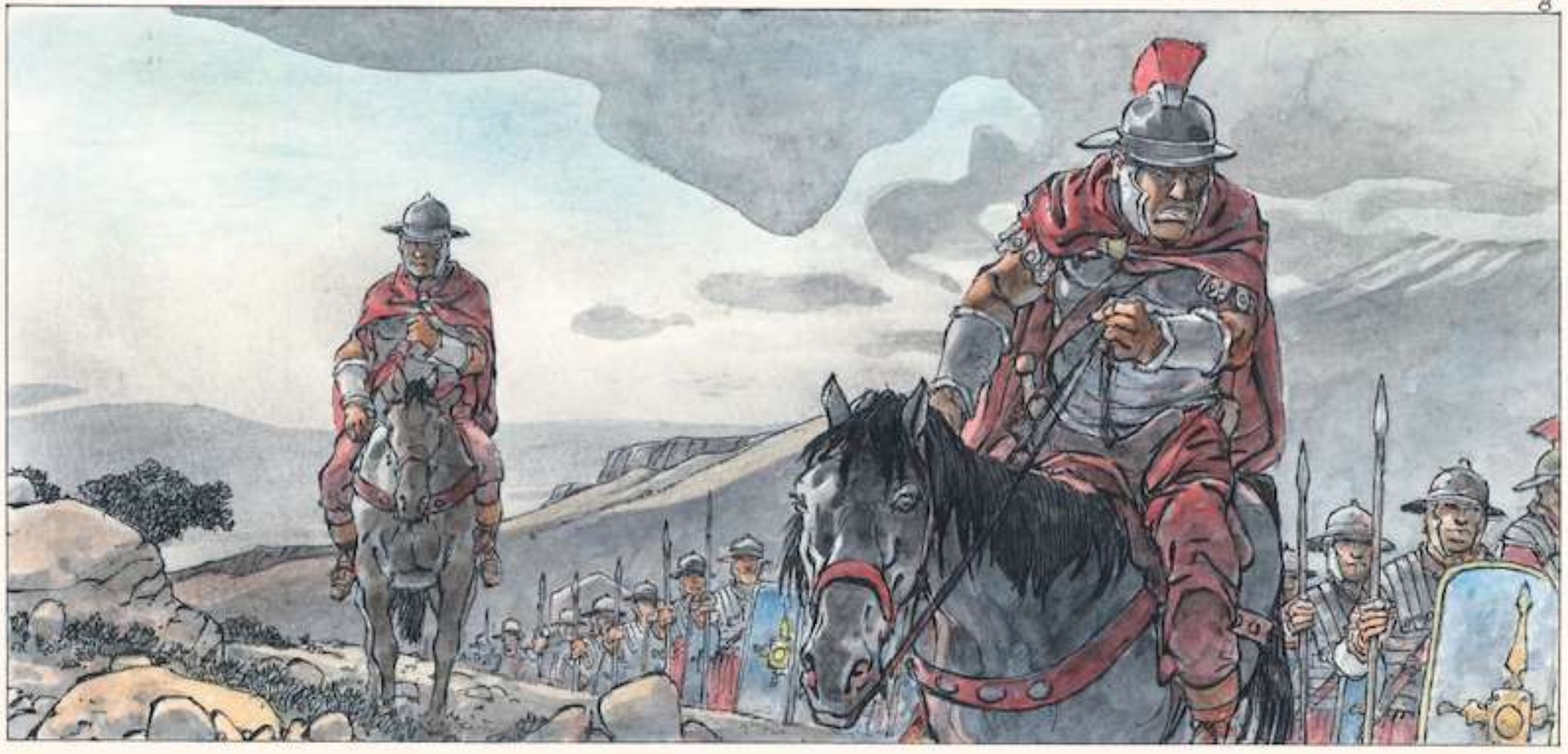

84 après J.-C. Melonius Brigantus, connu sous le nom du “Picte”, est reconnu pour sa monstruosité et ses prouesses martiales impressionnantes. Sa légion a été envoyée en Écosse, pour conquérir le pays... Brigantus - Banni est le premier volume d'un diptyque édité par Le Lombard, signé par Hermann et Yves H. Bienvenue en territoire picte...

07/02/2024, 14:31

Quand les légionnaires romains marchaient sur l'Écosse

Dans la centurie, Melonius Brigantus, surnommé « Le Picte », est une figure célèbre. Considéré comme un monstre et une force de combat redoutable, il incarne la sauvagerie que les légions romaines sont venues affronter en Écosse. Premier tome d'un diptyque publié par Le Lombard, Brigantus est signé Hermann et Yves H... Plongée dans la légion romaine.

02/02/2024, 11:32

Des chevaliers robots : du jamais-vu l'époque du roi Arthur

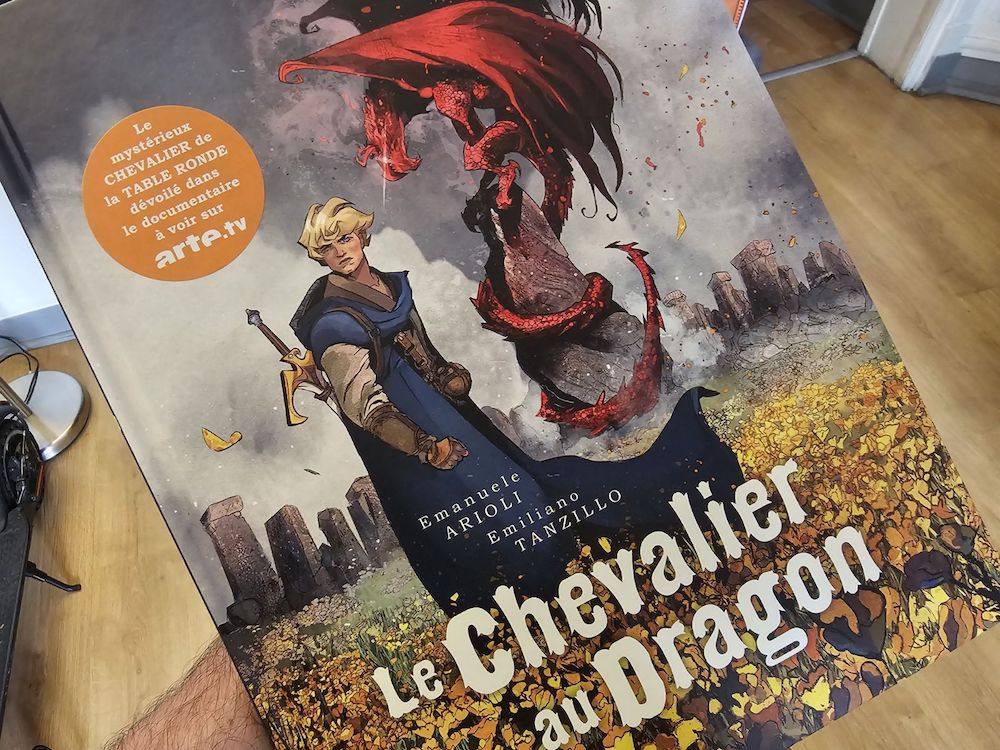

LeChevalierAuDragon – Emanuele Arioli aura passé dix années de recherches pour mettre à jour l’histoire de Ségurant, le chevalier au dragon, oublié de la Table ronde. Avec le dessinateur Emiliano Tanzillo, ils publient un album reprenant cette histoire chez Seuil Jeunesse. Le scénariste commente, avec nous, des séquences choisies.

21/11/2023, 16:33

#ActuaLittéAime : un mille-feuille pour Jean Teulé

L’histoire du roi qui ne voulait pas mourir a été publié le jour anniversaire du décès de Jean Teulé. Initialement intitulée Panique à bord de Louis XI, l'oeuvre a été rebaptisée peu avant la disparition de l'auteur, un changement de titre que son éditrice, Betty Mialet, considère comme un signe prémonitoire...

18/11/2023, 10:00

#ActuaLittéAime : un mille-feuille cruel

La crudelitas, enveloppée dans les voiles sombres de la trop humanité, se déploie comme une ombre implacable sur l'âme, insufflant terreur et désespoir. Tel un spectre antique, elle murmure à travers les âges, un écho persistant des heures de furie...

11/11/2023, 10:00

(Dé)rangée, coup de coeur de novembre des Amis de la bande dessinée

Fidèles à leur habitude, les Amis de la bande dessinée ont désigné leur coup de cœur pour le mois de novembre. Fondé par Adrien Laurent, ce groupe monté sur Facebook compte près de 122.000 abonnés. Gloire donc à Manon Henaux et Greg Blondin, pour le tome 1 de leur album (Dé)rangée.

08/11/2023, 10:20

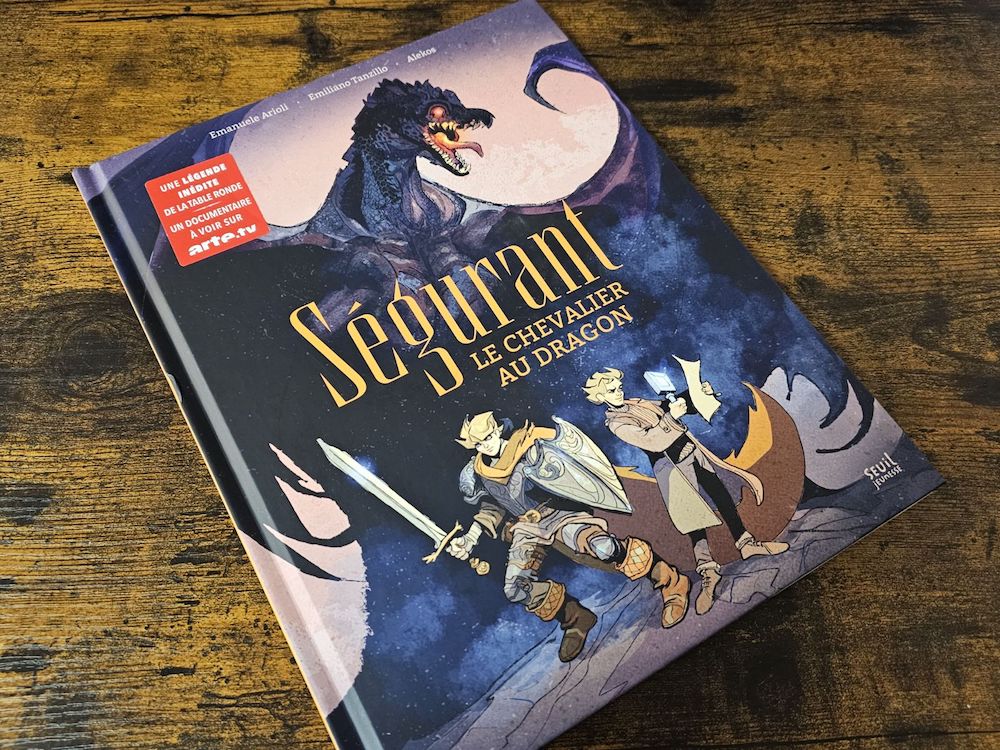

Des lions, une taverne, un dragon : un chevalier a chamboulé le monde médiéval

LeChevalierAuDragon – Emanuele Arioli aura passé dix années de recherches pour mettre à jour l’histoire de Ségurant, le chevalier au dragon, oublié de la Table ronde. Avec le dessinateur Emiliano Tanzillo, ils publient un album reprenant cette histoire chez Seuil Jeunesse. Le scénariste commente sur Instagram, des séquences choisies, que nous republions ici.

08/11/2023, 09:41

#ActuaLittéAime : un mille-feuille visionnaire

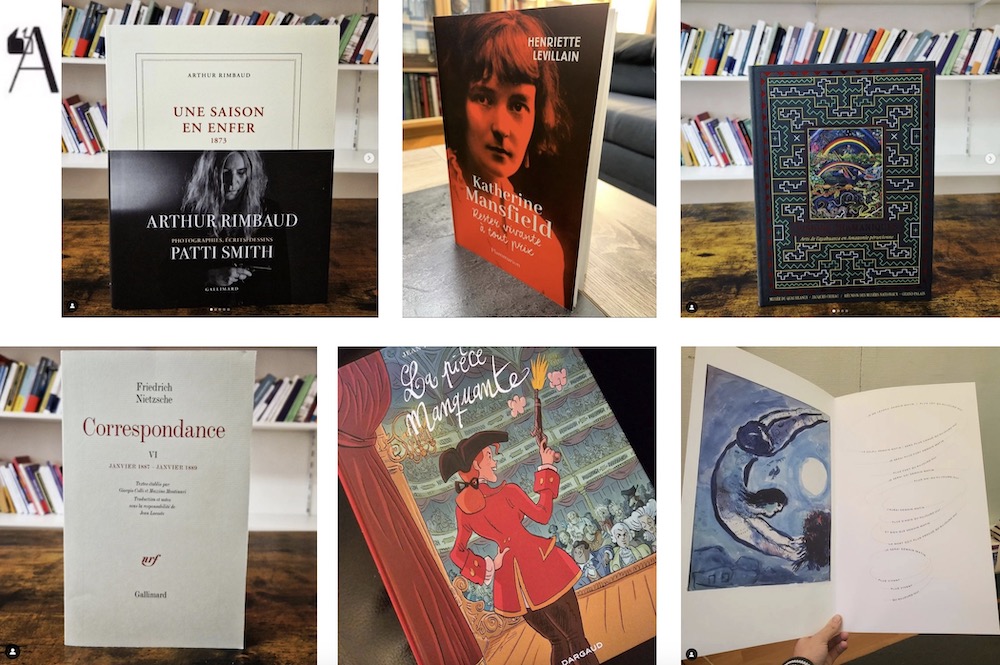

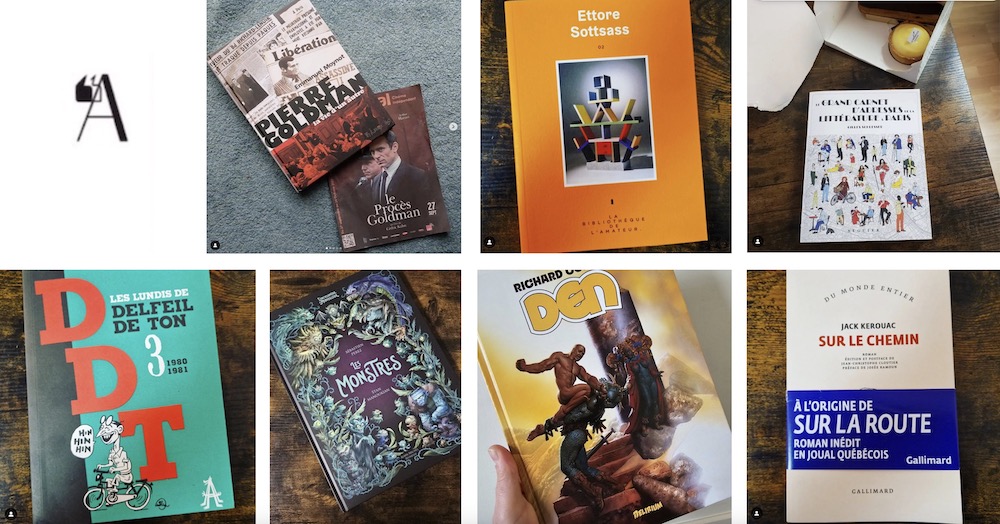

Friedrich Nietzsche, Arthur Rimbaud, Robert Desnos, William S. Burroughs... Les visionnaires ont cette capacité rare de voir au-delà de l'horizon du donné, anticipant les nécessités de demain là où d'autres ne voient que la routine du quotidien.

04/11/2023, 10:30

#ActuaLittéAime : un mille-feuille zinzin

Jack Kerouac, Pierre Goldman, Ettore Sottsass ou Delfeil de Ton, ils n'auraient pas fait tout ça s'ils n'étaient pas un petit peu chtarbés... Cette déraison est souvent le berceau de la création, car c'est dans l'abandon des conventions que l'esprit trouve sa liberté la plus authentique.

28/10/2023, 10:00

Ségurant : Un dragon, j'ai vu un dragon... et son chevalier... (2/2)

Lechevalieraudragon – Le chercheur Emanuele Arioli, associé à l'illustrateur Emiliano Tanzillo, vient de lancer chez Dargaud un ouvrage graphique au scénario envoûtant. Pendant près d'une décennie, cet expert en littérature et langage du Moyen Âge de l'université polytechnique des Hauts-de-France a sillonné les archives internationales pour redécouvrir le récit perdu de Ségurant, le preux face au dragon...

23/10/2023, 12:57

Un dragon, j'ai vu un dragon... et son chevalier : Ségurant

Lechevalieraudragon – L’universitaire Emanuele Arioli et le dessinateur italien Emiliano Tanzillo ont publié chez Dargaud une bande dessinée à l’histoire fantastique. Durant une dizaine d’années, le maître de conférence en langue et littérature médiévale à l’université polytechnique des Hauts-de-France a parcouru les bibliothèques du monde pour reconstituer l’histoire oubliée de Ségurant, le chevalier au dragon…

16/10/2023, 15:54

Les amis de la BD inaugurent leur coup de coeur mensuel

Fondé par Adrien Laurent, les Amis de la BD rassemblent une équipe de passionnés. Ensemble, ils partagent et informent, via Facebook et le site internet, une communauté de plus de 117.000 personnes à ce jour. Ce mois-ci, ils mettent les projecteurs sur la BD Les vies de Charlie, le coup de coeur d’Octobre.

12/10/2023, 10:53

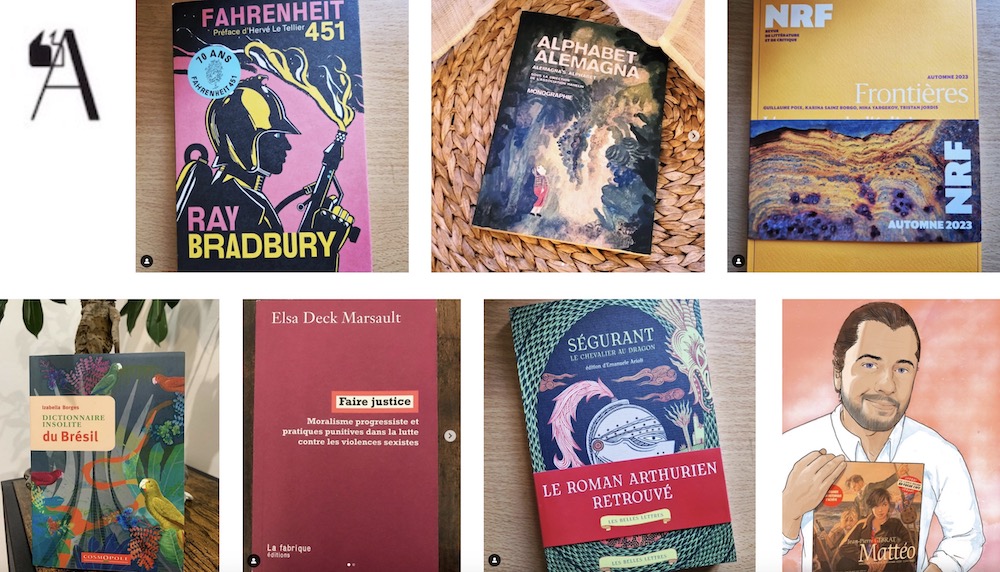

#ActuaLittéaime : un mille-feuille chevaleresque

Du lourd avec un récit inédit de la littérature médiévale arthurienne : Ségurant, le chevalier au dragon. En parallèle, il faut dire un dernier au revoir à Mattéo, héros de la saga historique de la première moitié du XXe siècle... Mais le repos du guerrier est mérité ! Elsa Deck Marsault examine de près l'engagement militant, entre volonté de justice sociale et abolitionnisme pénal, et approches punitives pour traiter les conflits internes...

07/10/2023, 10:00

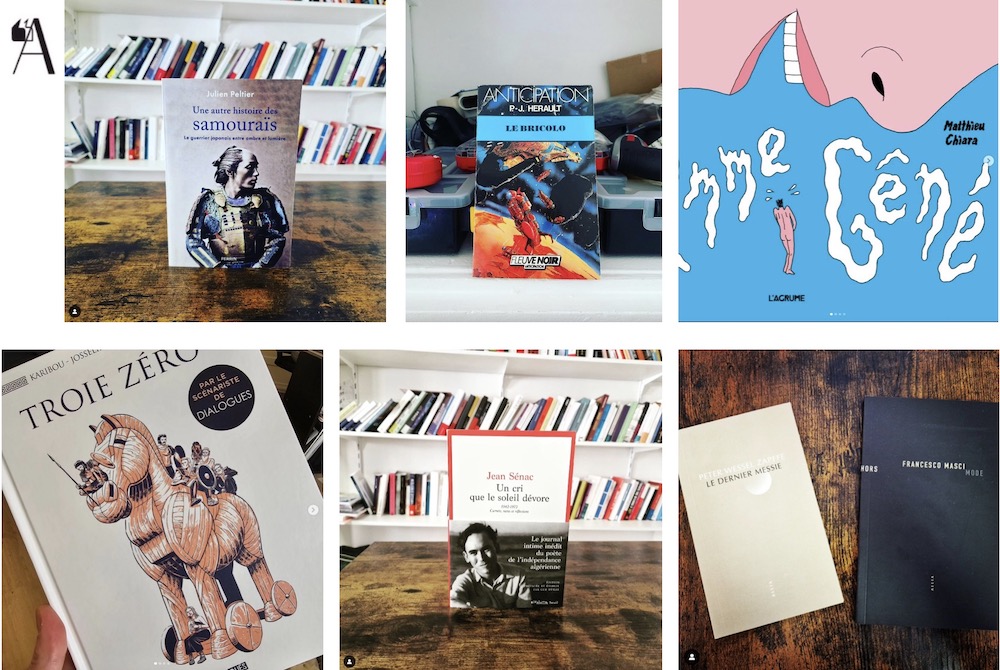

#ActuaLittéAime : un mille-feuille dévorant

Le soleil dévorant de l'Algérie dardait ses rayons ardents, embrasant le paysage et les crânes de la lumière implacable d'un poète assassiné. L'homme gêné est lui esseulé, jusqu'à sa rencontre avec la nouvelle voisine. Son quotidien désoeuvré est à présent rempli de vie, de pensées dévorantes et...de doutes.

30/09/2023, 10:05

#ActuaLittéAime : un mille-feuille artiste

En artiste, le peintre et sculpteur italien Amedeo Modigliani a su capturer l'essence de la mélancolie dans ses portraits allongés et ses nus. L'assassinat peut également être considéré comme un des beaux-arts, surtout quand la féminité rencontre le crime. Et quelle résistance, acte premier de toute oeuvre essentielle, quand des travailleurs sans-papiers employés par l’entreprise Chronopost d’Alfortville, ont mené une grève victorieuse de plusieurs mois.

23/09/2023, 10:00

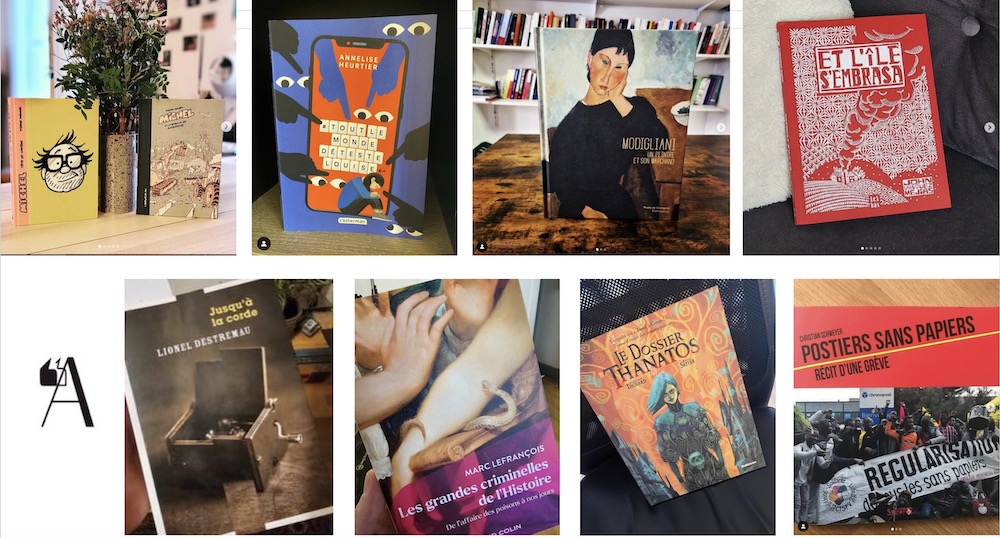

#ActuaLittéAime : un mille-feuille sanguinaire

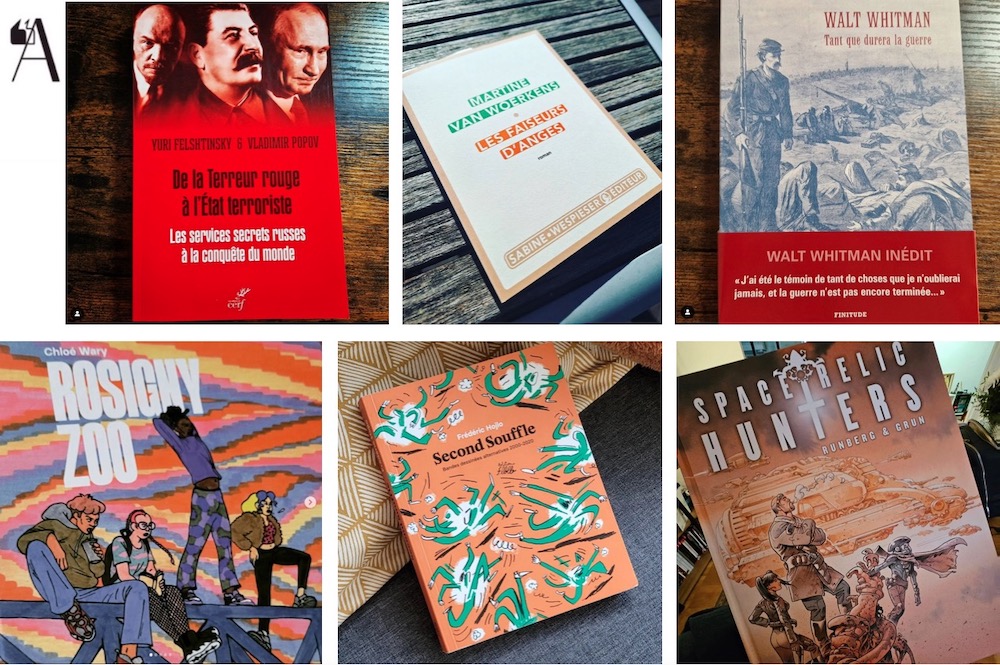

Purges, famines orchestrées ou camps de travail forcé, le communisme soviétique de Staline et cie n'était pas de la rigolade. La Guerre de Sécession non plus, même par les yeux d'un poète... Et quand un conflit religieux interplanétaire dévaste la galaxie, quatre divinités établissent un nouvel empire : dictature violente et répressive, à la Lavrenti Beria.

16/09/2023, 10:00

#ActuaLittéaime : un mille-feuille idéal

Au cœur des banlieues françaises, Les conditions idéales de Mokhtar Amoudi suit Skander, un jeune homme déchiré entre les attentes de la société liées à ses origines et son rêve de devenir avocat : le combat des jeunes face au déterminisme social, avec une plume touchante et éclairée par l'amour de la littérature.

09/09/2023, 10:00

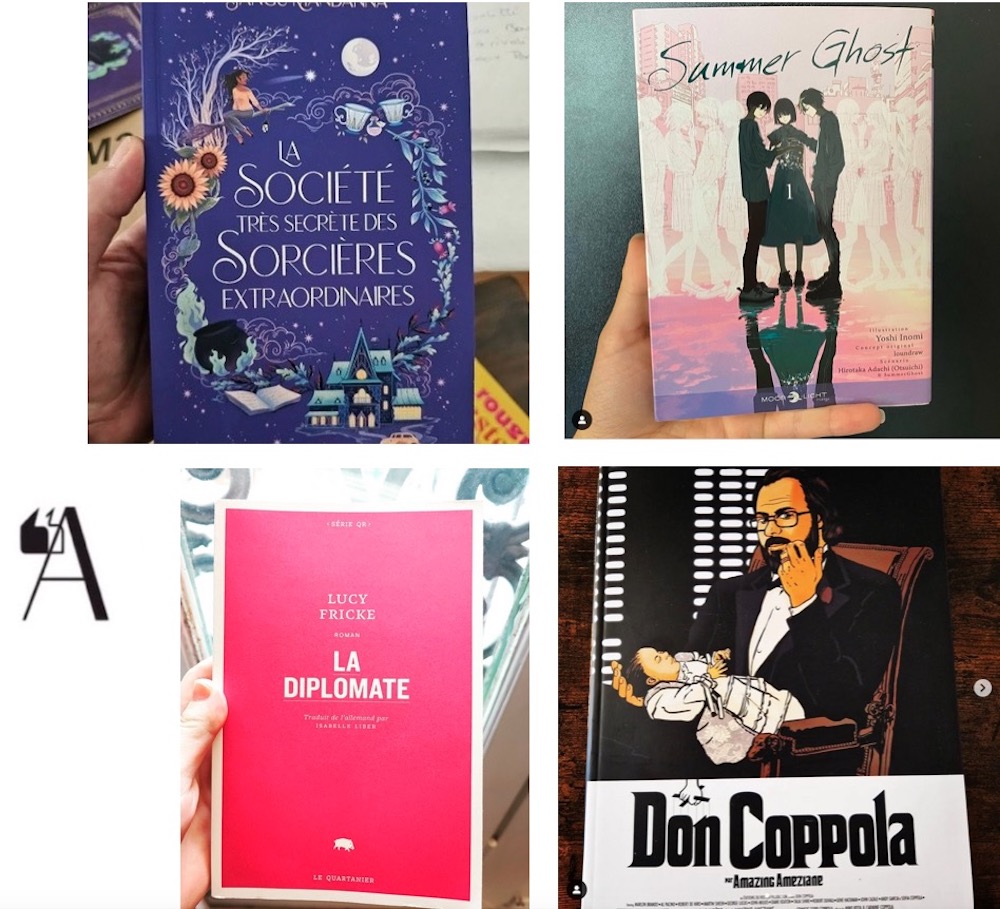

#ActuaLittéAime : un mille-feuille fantomatique

« Vouloir mourir ou ne pas vouloir mourir... Il n'y a que les vivants qui ont ces soucis. Les fantômes ne se posent pas de questions. Ils sont déjà morts. Profite d'être en vie pour faire des choses que seuls les vivants peuvent faire. »

02/09/2023, 09:00

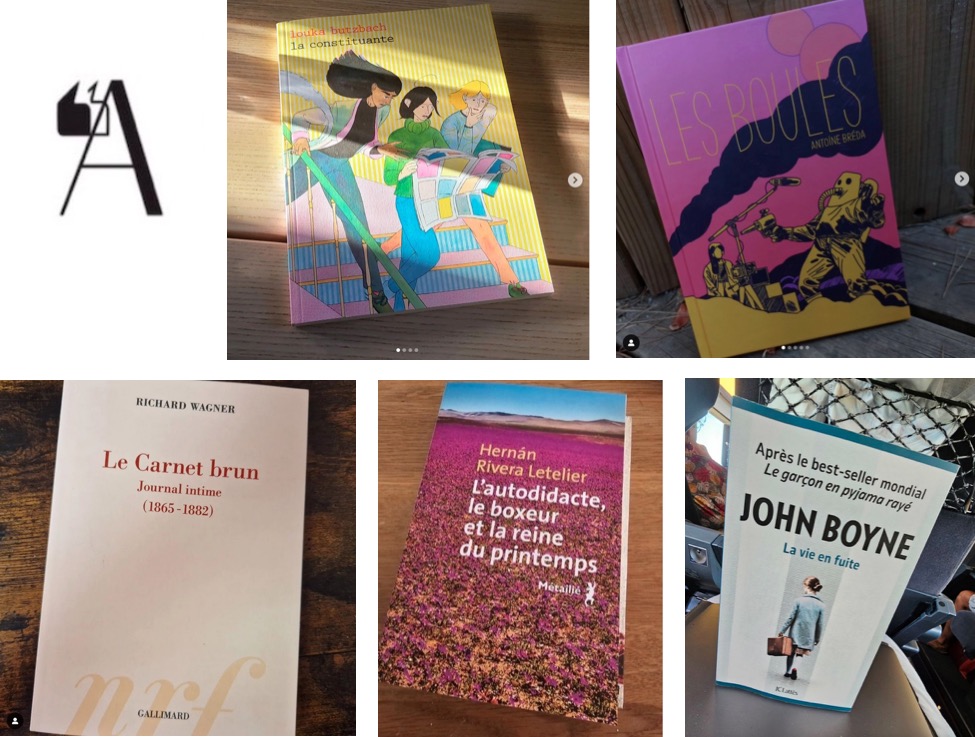

#ActuaLittéAime : un mille-feuille bagarreur

Un mineur (qui descend à la mine) et boxeur dans le nord du Chili, entre misère, foi et machisme, un compositeur-théoricien-malin-génial, ou Maximillienne qui débarque à Paris en autostop pour vivre de la bande dessinée, trois bagarreurs chacun dans leur secteur.

26/08/2023, 10:00

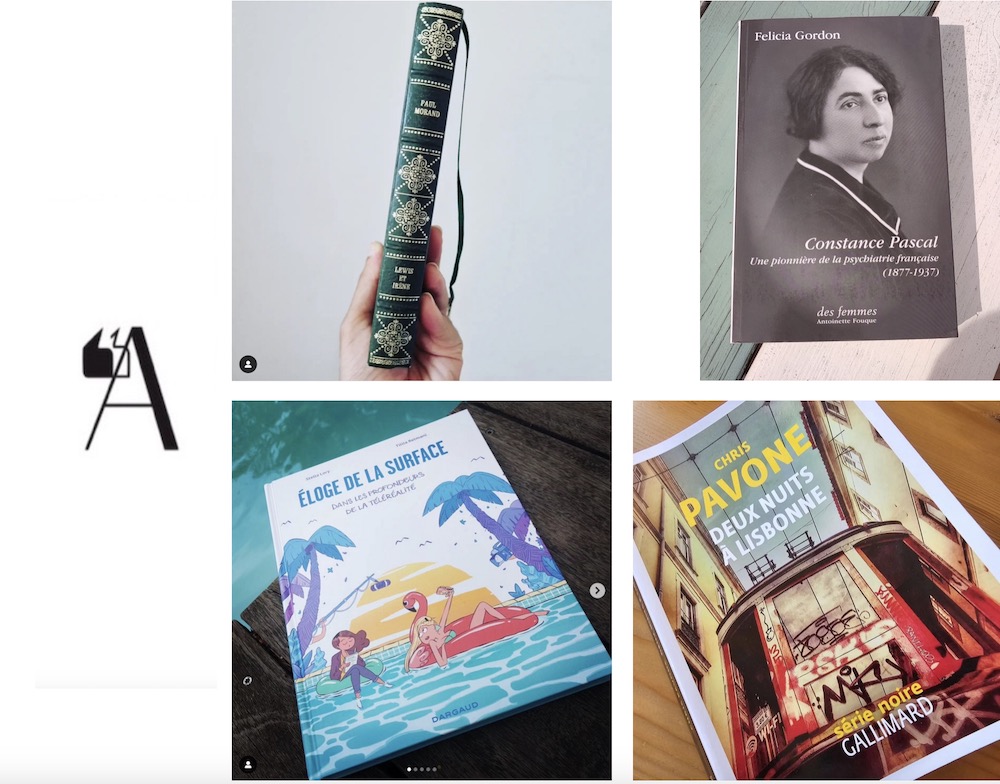

#ActuaLittéAime : un mille-feuille marin

« Il y a la mer et qui peut l’épuiser ? », se demandait Sylvain Tesson, peut-être les candidats de téléréalité à force de conversations creuses comme la terre de Joseph Altairac ? Les plages de Lisbonne, quel bonheur des derniers jours, qui certainement se finit alors qu’août se ferme doucement, en même temps que Paris Plage... Le soir, la capitale portugaise dissimule ces histoires de vengeance…

19/08/2023, 10:00

#ActuaLittéAime : un mille feuille réputé

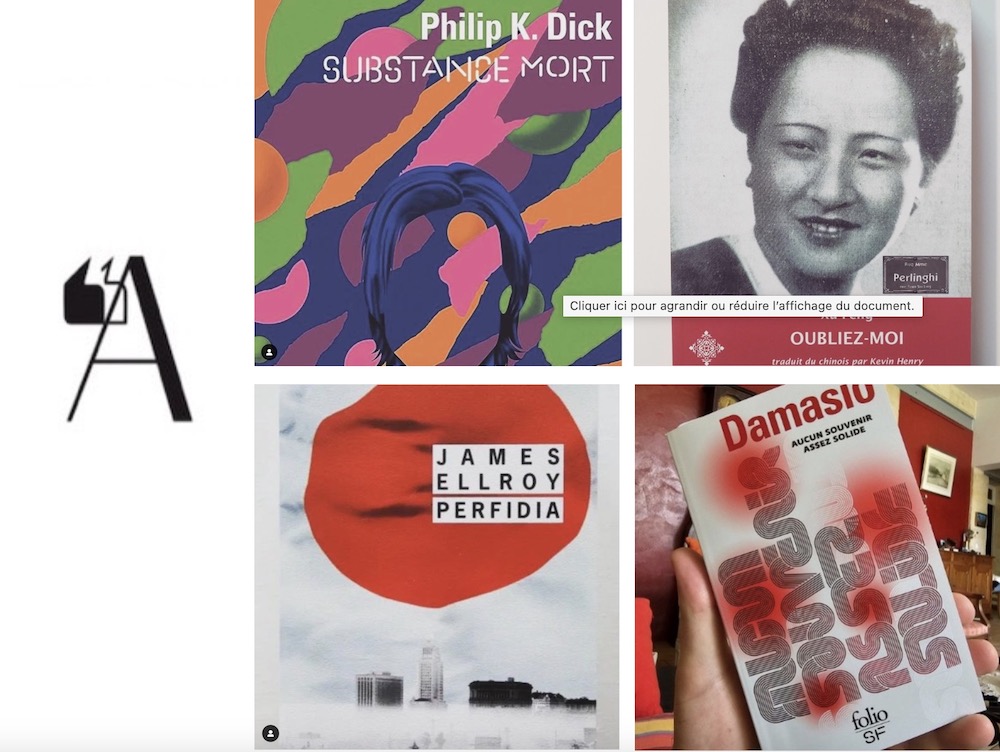

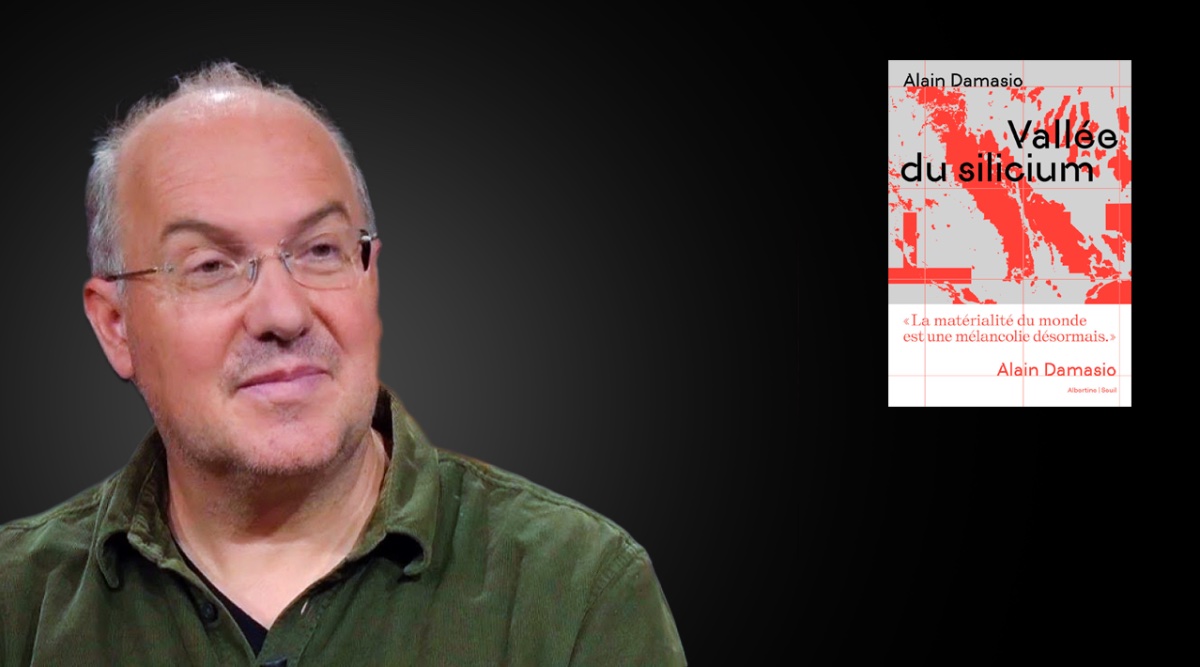

Avec Alain Damasio, la mémoire est comme du verre fin, si facile à fissurer sous la pression du temps... Pour James Ellroy, face aux tumultes de la vie, elle est semblable à une plume emportée par le vent... Avec Philip K. Dick, les souvenirs se mélangent, disparaissent, se transforment, à cause des clés de la perception...

12/08/2023, 10:00

“Histoires, poèmes, recettes...” : TikTok s'essaie aux textes

Présentant une innovation qui lui permet de lorgner vers Instagram et Facebook, le réseau social chinois TikTok peut désormais accueillir des textes jusqu'à 1000 caractères. Ces écrits pourront être affichés sans photo ni vidéo, ce qui peut, de prime abord, étonner pour un réseau social tourné vers l'image.

31/07/2023, 15:30

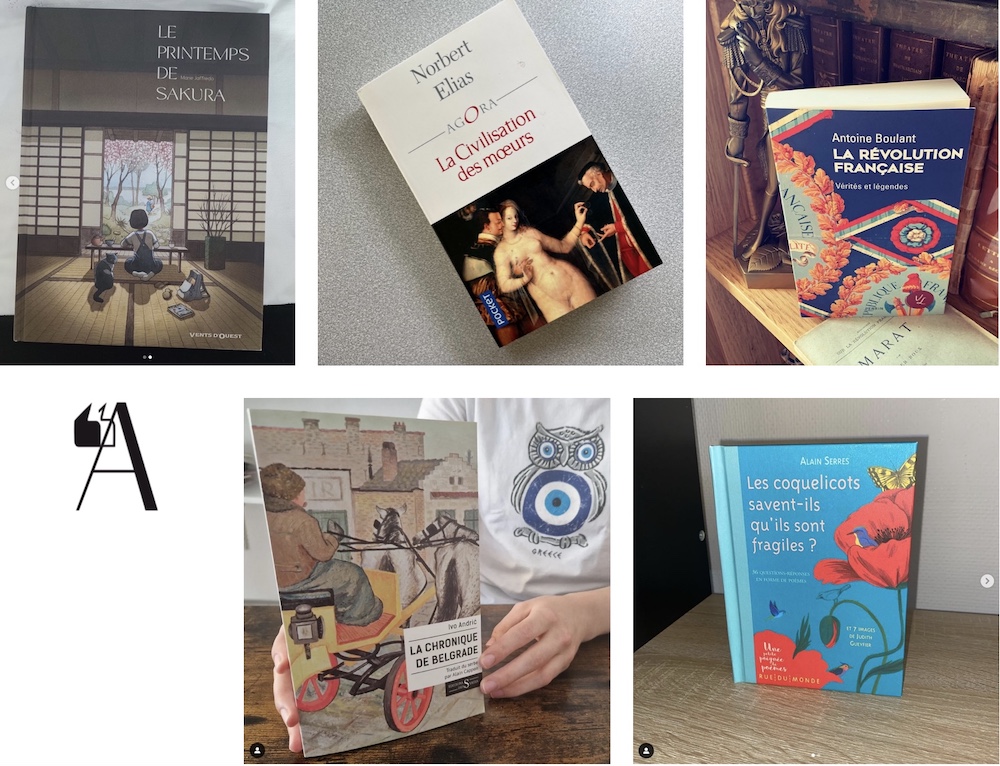

#ActuaLittéAime : un mille-feuille fragile

La fragilité d'une révolution réside dans l'équilibre précaire entre une aspiration au changement et la nécessité de maintenir, au minimum, une cohésion sociale. Ce corps, qui intègre le multiple, se fracture toujours dans les périodes de guerre. Et que dire de la civilisation, cette dynamique de la complexité, délicate comme les gestes d'une ballerine, et exigeante comme la poigne d'un corset...

23/07/2023, 10:00

#ActuaLittéAime : un mille-feuille insulaire

Une île volcanique entre l'Italie et la Tunisie : « Enfermée par la mer dans la très profonde solitude de la Méditerranée, celle-ci a un regard vertical : depuis la terre arrachée avec les ongles au volcan, cultivée avec peine et selon un ordre presque métaphysique, droit jusqu’au ciel qui dans les nuits limpides, montre les cultures serrées, intensives,de ses constellations. Peut-être est-il aussi la métaphore de la condition humaine. »

08/07/2023, 10:35

#ActuaLittéAime : un mille-feuille tempétueux

La tempête de Mario Neri est un beau paysage dans lequel la détresse est affective. Chez Jean Eustache, l'ouragan est soit sourd, soit volubile, caché derrière un flot de paroles. Tyst veut en sortir de l'orage : « Me perdre dans un autre monde. Si cet autre monde doit être de ma fabrication, la démence vaut mieux que de coûteux psychotropes. »

01/07/2023, 10:00

#ActuaLittéAime : un mille-feuille déroutant

Marcin Kania est sans doute un assassin... Un matin, le visage tuméfié, il se rend à son groupe de discussion tourné vers la sortie de la dépendance. Il n’avait pas bu depuis quasi deux ans... Déroutant, mais pas moins que la dégaine de Taj et ses aventures intersidérantes. Sorte de Pierre Richard extraterrestre et immémorial, il cumule les ennuis comme d’autres les collections de papillons.

24/06/2023, 09:00

Jack Kirby, condamné à rester dans l'ombre de Stan Lee ?

Ce vendredi 16 juin sortait sur la plateforme de streaming Disney+, un documentaire sobrement intitulé Stan Lee. Ce dernier retrace la vie et la carrière de celui que l’on considère comme le père fondateur de l’écurie Marvel. Cependant, cette production en oublie un autre acteur essentiel dans la naissance de cette immense industrie : Jack Kirby. Sa descendance a d’ailleurs pris soin de remettre les points sur les i...

20/06/2023, 09:43

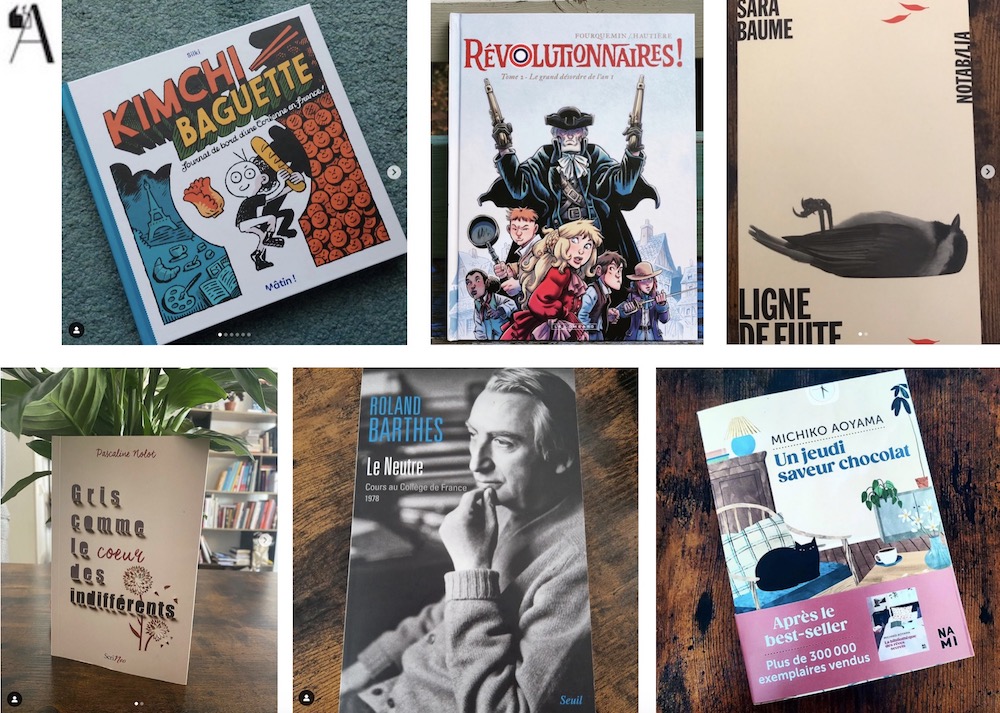

#ActuaLittéAime : un mille-feuille chocolaté

Il y a la femme chocolat d'Olivia Ruiz et le jeudi saveur chocolat de Michiko Aoyama. Nous voilà transportés dans le petit café Marble de Tokyo auprès de ses fidèles visiteurs. Dissimulées au fond d’une ruelle, les trois tables menues de bois brutes suffisent à accueillir tout un véritable écosystème. Mme Cacao y vient chaque semaine pour rédiger une longue lettre en anglais…

17/06/2023, 10:00

#ActuaLittéAime : un mille-feuille combatif

Combative, il aura fallu que Rose Valland le soit à la recherche des milliers d'œuvres d’art spoliés. La linguistique serait-elle un combat ? Quand il s'agit de remettre en question les clichés déclinistes proférés à propos de la langue française par des incompétents, visiblement. C'est enfin la lutte en commun quand des femmes mettent au jour le comportement d'un ancien roi du Paf : PPDA...

10/06/2023, 10:00

Oxfam VS J.K. Rowling : transphobie or not to be

Organisation internationale à but non lucratif, Oxfam International est aujourd’hui dans la tourmente. Dans le cadre de leur campagne du mois des fiertés « Protect the Pride », l’organisme a fait un faux pas qu’Internet n’est pas prêt de lui pardonner. Une courte vidéo, postée sur leur compte Twitter, montrait un personnage en colère ressemblant à J.K. Rowling portant un badge TERF…

07/06/2023, 18:09

Autres articles de la rubrique Médias

Les figures du mal, “d’excellents sujets de roman”

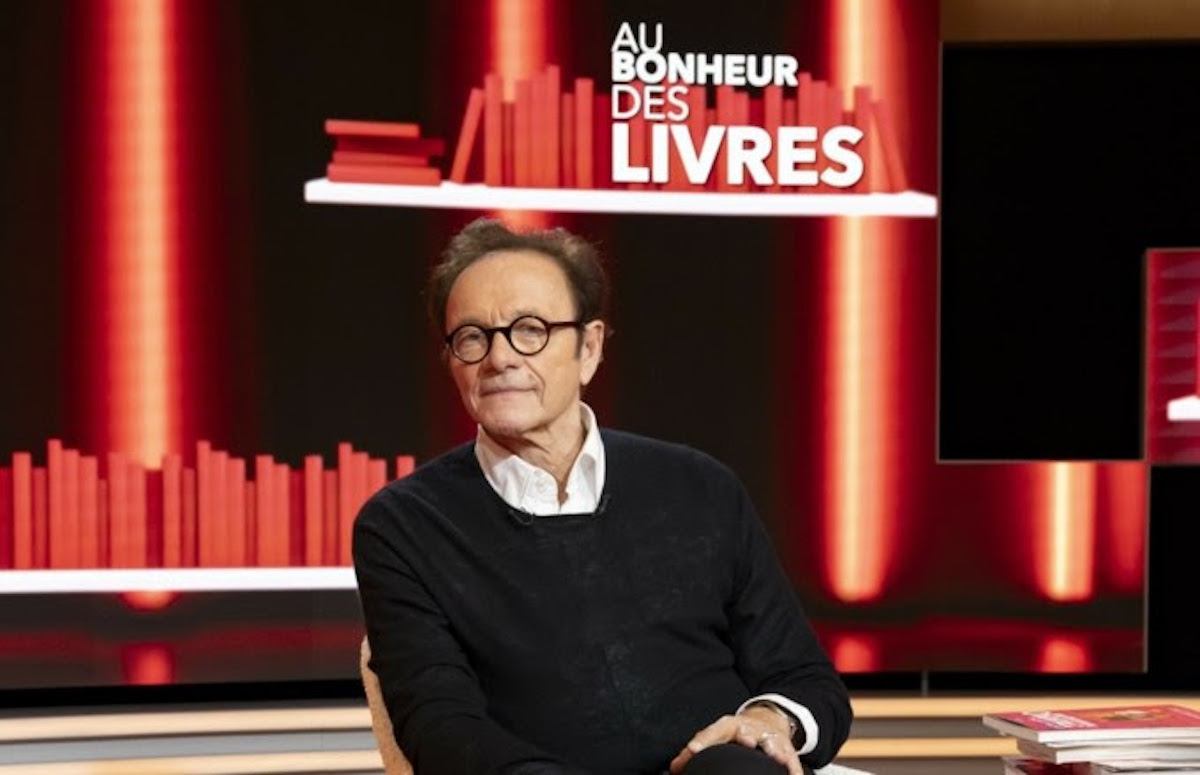

Dans Au bonheur des livres, sur Public Sénat, Guillaume Durand recevra ce vendredi 19 avril plusieurs invités afin d'évoquer ces figures quasi maléfiques de l'histoire. Le maréchal Paulus ou Heinrich Himmler posent la question de l'origine comme de la banalité du mal, à travers le regard d'écrivains...

19/04/2024, 16:04

Arte diffuse un portrait de l’écrivaine autrichienne Elfriede Jelinek

Lauréate du Prix Nobel de littérature en 2004, l'autrice autrichienne Elfriede Jelinek a récemment été ordonnée Commandeur dans l'ordre des Arts et des Lettres. À cette occasion, Arte diffuse, le lundi 13 mai 2024 à 22h50, un portrait de la créatrice, plutôt réticente à se dévoiler dans les médias...

19/04/2024, 14:34

Le Cochon de Noël de J.K. Rowling bientôt au cinéma

Publié en octobre 2021, quelques semaines avant les fêtes de fin d'année, Jack et la grande aventure du Cochon de Noël marquait le retour de J.K. Rowling, sans pseudonyme, mais avec de la magie. La magie de Noël, s'entend. Ce récit serait entré en première phase de production, en vue d'une adaptation cinématographique.

18/04/2024, 09:55

Netflix adapte le chef d'oeuvre de Gabriel García Marquez, Cent Ans de Solitude

Netflix a récemment dévoilé un teaser pour son adaptation en série du plus célèbre des romans de Gabriel García Marquez, et peut-être de la littérature sud-américaine, Cent Ans de Solitude. Prévue pour une sortie plus tard cette année, cette adaptation marque la première transposition du classique de la littérature à l'écran.

17/04/2024, 18:29

Consuelo et Antoine de Saint Exupéry, un couple de haut vol

Régulièrement séparé par les océans ou par les obligations aériennes de Saint-Exupéry, le couple n'en est pas moins resté amoureux et soudé pendant près de 15 ans, jusqu'à la mort de l'écrivain en 1944. Un documentaire inédit retraçant leur histoire sera diffusé le vendredi 10 mai à 23h10, sur France 5.

17/04/2024, 11:24

Les animaux de La Fontaine se prêtent aux Jeux

Le compte à rebours est lancé, à 100 jours du début des Jeux olympiques — et un peu plus avant les Jeux paralympiques. Pour les plus jeunes, à partir de 6 ans, une série d'animation, Les jeux de La Fontaine, porte l'esprit olympique en l'appliquant aux personnages du célèbre fabuliste.

17/04/2024, 09:27

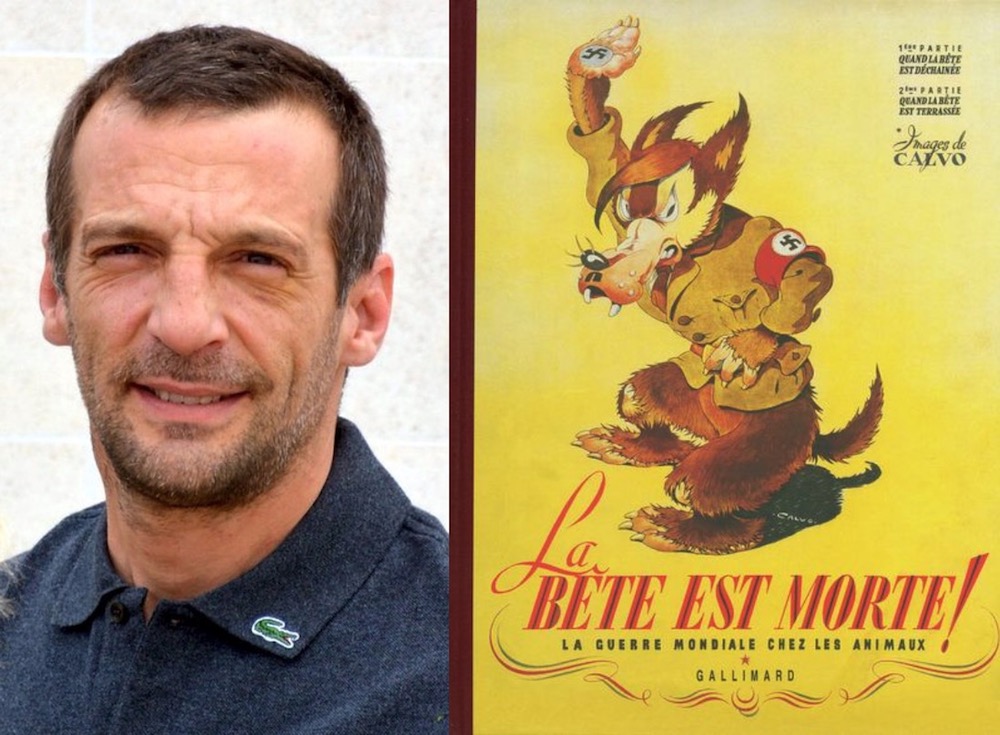

Mathieu Kassovitz et des lapins français contre les loups nazis

Le réalisateur de La Haine ou des Rivières Pourpres fait son retour derrière la caméra, près de 13 ans après son dernier film. Il adaptera La Bête est morte !, bande dessinée écrite sous l'Occupation et publiée à la Libération.

16/04/2024, 10:49

Shoot the book ! : 18 livres présentés au Festival de Cannes 2024

Depuis 11 ans, Shoot the book ! permet la rencontre d'éditeurs et de producteurs de films, en vue de l'adaptation de livres en films. Cette année, ce sont en tout 18 ouvrages qui seront pitchés lors du Festival de Cannes, les 16 et 17 mai 2024.

15/04/2024, 10:49

Si on lisait à voix haute : les 9 finalistes face à François Busnel

Ils étaient plus de 120 000, ils ne sont plus que neuf. Neuf finalistes âgés de 11 à 17 ans, qui se disputeront le titre de meilleure lectrice ou meilleur lecteur de France lors d'une grande soirée diffusée en première partie de soirée sur France 5 au printemps.

11/04/2024, 15:06

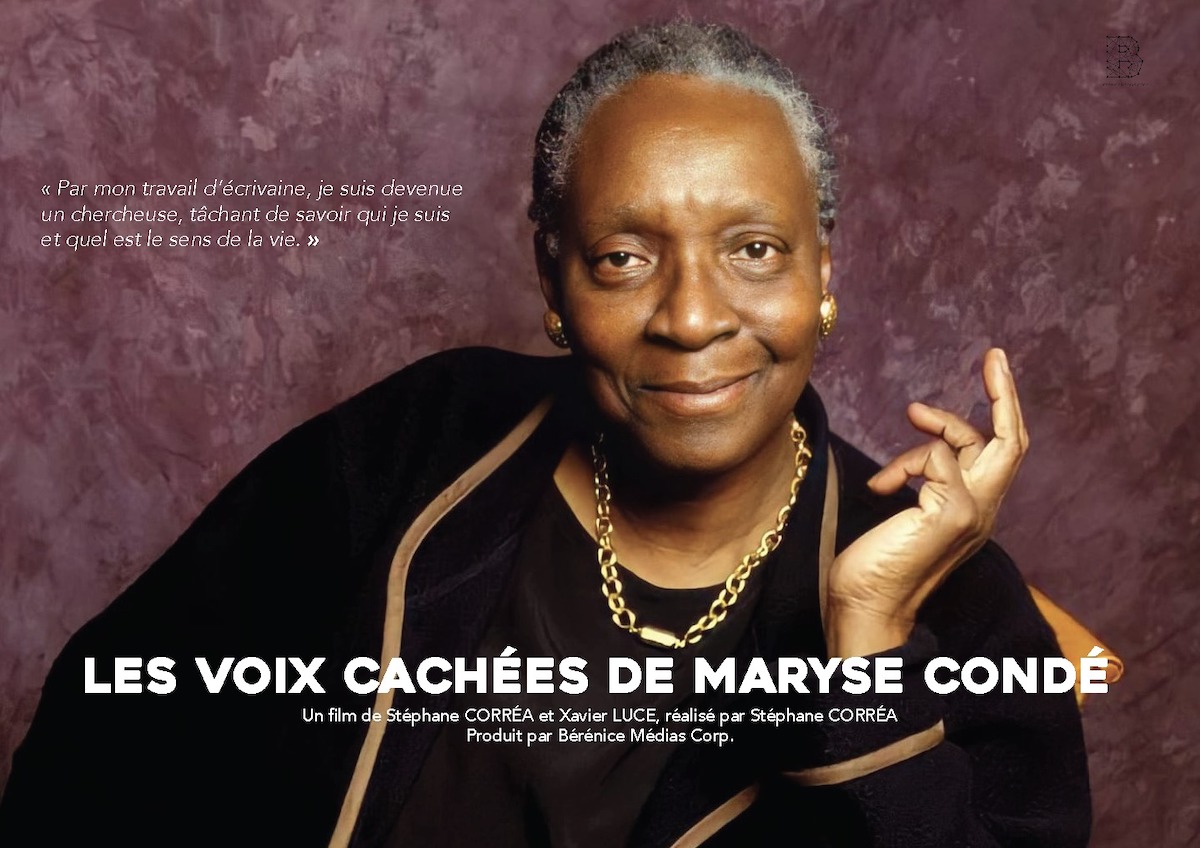

Une émission spéciale pour l'hommage national à Maryse Condé

Le pôle Outre-mer de France Télévisions annonce une programmation exceptionnelle à l'occasion de l'hommage national rendu à Maryse Condé, décédée le 2 avril 2024. La Bibliothèque nationale de France (BnF) accueillera cette cérémonie, en présence du président de la République Emmanuel Macron. Une retransmission est prévue, le lundi 15 avril en direct à partir de 15h45.

11/04/2024, 11:44

France TV diffuse du Shakespeare pour le printemps

À partir du dimanche 28 avril, Othello mis en scène par Jean-François Sivadier sera disponible sur france.tv et Culturebox. Vendredi 3 mais, à 21h05, c'est Roméo et Juliette, joué l'an dernier à l'Opéra de Paris Bastille, qui sera diffusé sur France 5.

10/04/2024, 13:08

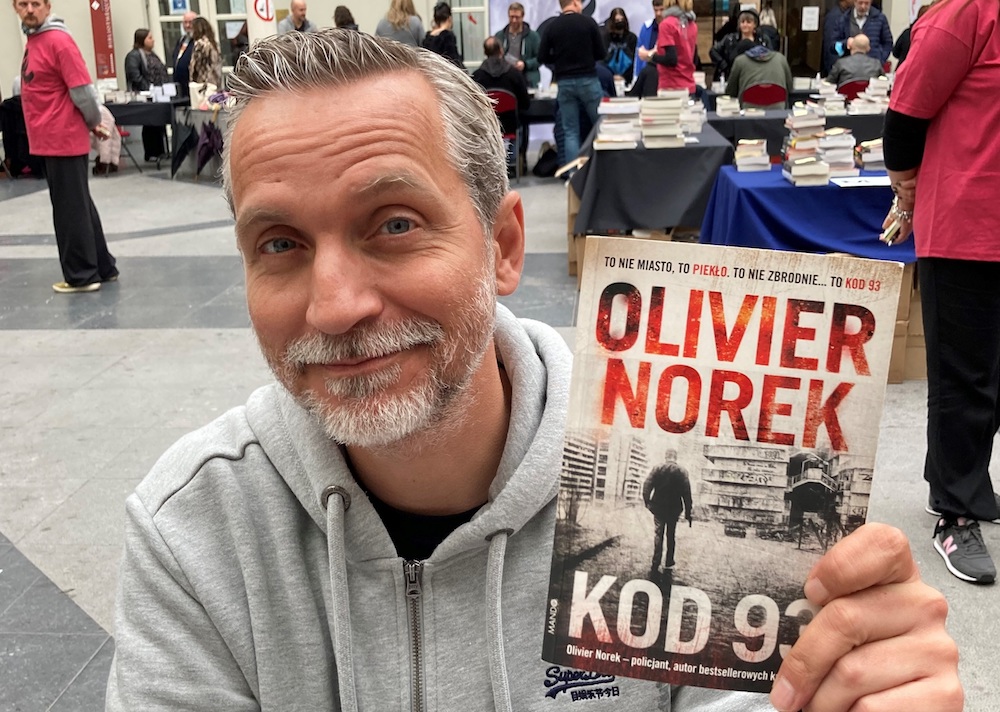

France Télévisions tourne l'adaptation de Surface d'Olivier Norek

France 2 a lancé la production d'une mini-série adaptée du roman Surface d'Olivier Norek. Menée par les acteurs Laura Smet et Tomer Sisley, et réalisée par Slimane-Baptiste Berhoun, la série sera tournée en Belgique et en France, et plus précisément en Occitanie, lieu de l'intrigue du polar publié en 2019.

09/04/2024, 12:08

La Grande Librairie : poésie et imaginaire pour guérir de vies imparfaites

Cette semaine, dans La Grande Librairie, on se souvient d’hier, on imagine demain et on réfléchit sur aujourd’hui ! Cinq écrivains dissertent sur nos vies imparfaites, leurs fractures et leurs fragilités, et font le pari, pour y répondre, de l’imaginaire et de la poésie. Rendez-vous avec Augustin Trapenard ce 10 avril, à 21 h, sur France 5.

07/04/2024, 10:48

Alain Damasio, Muriel Morelli et Brecht Evens sur France Culture

Pour cette nouvelle semaine, du lundi 8 au dimanche 14 avril, la station de radio publique France Culture prévoit une grille de programmes riche et diversifiée, qui ne manque pas de réserver une place à la littérature. Avec, comme invités, Alain Damasio, Muriel Morelli ou encore Brecht Evens, parmi d'autres...

05/04/2024, 16:06

Maryse Condé et le “douloureux apprentissage de la liberté”

En hommage à Maryse Condé, disparue le 2 avril 2024, France 5 diffuse ce dimanche 7 avril un documentaire inédit entièrement consacré à l'autrice. Les voix cachées de Maryse Condé, réalisé par Stéphane Correa, explorera l'œuvre, mais aussi la vie avant l'écriture de la Guadeloupéenne.

05/04/2024, 09:44

Une nouvelle adaptation de Monsieur Ripley, sur Netflix

Ce jeudi sort sur Netflix une mini-série, Ripley, adaptée du roman Monsieur Ripley de Patricia Highsmith (trad. Jean Rosenthal). Après Plein Soleil en 1960 et Le Talentueux Mr Ripley en 1999, c'est la troisième fois que ce mystérieux personnage est porté à l'écran.

04/04/2024, 15:37

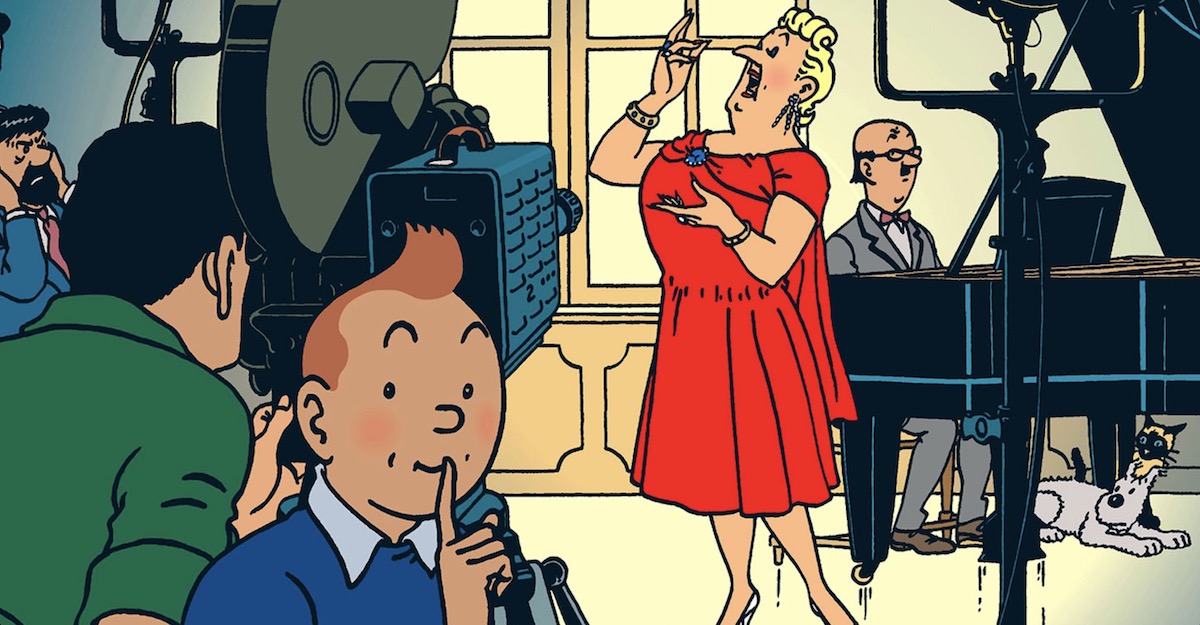

Les Bijoux de la Castafiore, film de Patrice Leconte, “tombé à l'eau”

Adapter l’aventure des bijoux volés au rossignol milanais, tout le monde en rêvait : le réalisateur Patrice Leconte avait même publié un dictionnaire, Tintin de A à Z chez Casterman. Un abécédaire exprimant toute l’affection d’un amoureux passionné par les histoires de Hergé. Sauf que non, définitivement, non : « Le projet est tombé à l’eau. »

30/03/2024, 14:20

Le génocide des Tutsis, drame du Rwanda, dans La Grande Librairie

Cette semaine, une émission très spéciale, d'écrits et d'histoire : 30 ans plus tard, La Grande Librairie convoque la mémoire du génocide des Tutsis au Rwanda. Des écrivains, remarquables, qui sont des survivants et qui témoignent autant qu'ils réfléchissent sur ce qui s'est passé et sur la façon dont on peut le transmettre. À leurs côtés, journalistes, historiens, artistes et romanciers.

30/03/2024, 10:21

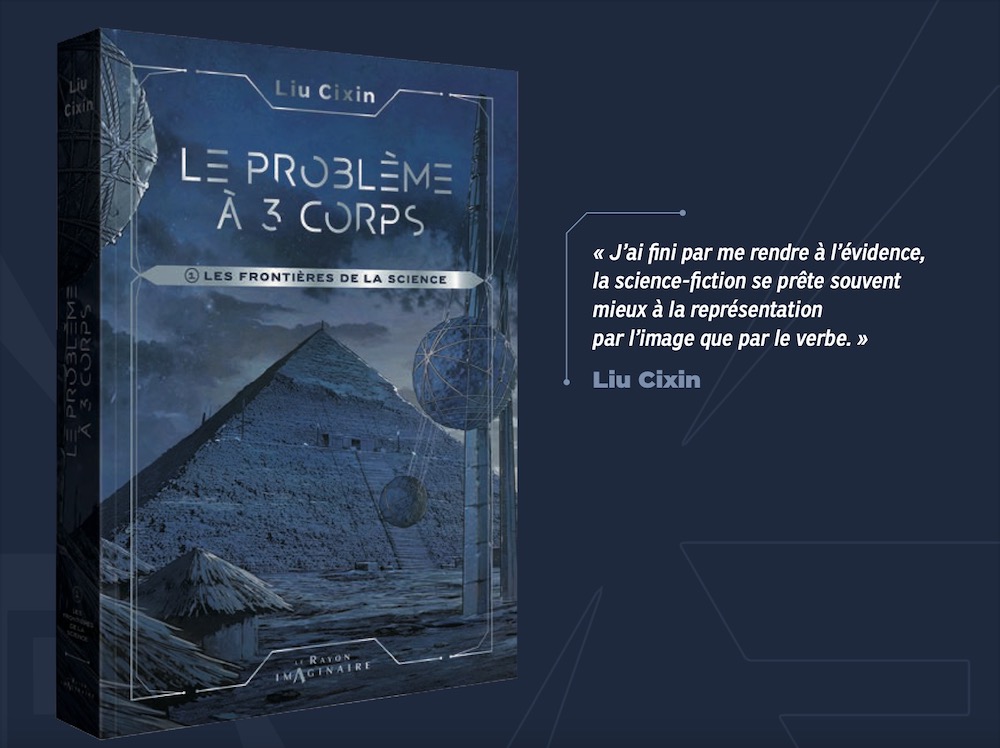

Liu Cixin : après Netflix, Le Problème à trois corps adapté en romans graphiques

En parralèle de l'adaptation Netflix sortie le 20 mars dernier, et après la parution d'une édition collector chez Actes Sud, Le Problème à trois corps de Liu Cixin a été adapté en webtoon par un studio d’illustrateurs chinois, sous la supervision étroite de l'auteur de SF chinois. Le Rayon imaginaire adapte l'œuvre en 5 tomes, qui paraissent entre ce 20 mars et février 2025.

29/03/2024, 17:44

Bertrand Mandico, Emily Bronté et Blaise Cendrars sur France Culture

La semaine prochaine, France Culture continue de tisser son riche panorama littéraire, promettant une exploration qui embrasse autant les nouveautés que les classiques, les romans que les essais, les débats que les entretiens.

29/03/2024, 12:11

Le Journal des enfants dit “Au revoir” à ses lecteurs

Fondé en 1984 par Béatrice d'Irube, dans le giron du quotidien régional L'Alsace, le Journal des enfants a pendant 40 ans éclairé l'actualité pour les jeunes de 8 à 14 ans. Faute d'abonnés, l'hebdomadaire se voit contraint d'abandonner les milliers de jeunes qui apprenaient à connaitre le monde avec lui.

28/03/2024, 11:54

Marvel Rivals, ou les super-héros dans l'arène des jeux de tir

Des combats en arène d'équipes de 6 joueurs, avec des environnements destructibles et une large sélection de héros et vilains à incarner, telle est la promesse de Marvel Rivals. Marvel Games a travaillé avec le développeur chinois NetEase pour venir concurrencer d'autres titres, notamment Overwatch, sur ce terrain très lucratif.

28/03/2024, 09:20

Les malvenus, une “guerre diabolique” orchestrée par Virginie Despentes

L'autrice Virginie Despentes a collaboré avec la réalisatrice Sandrine Veysset pour rédiger le scénario des Malvenus, un téléfilm autour d'une « guerre diabolique de voisinage ». Réunissant notamment Géraldine Pailhas et Jonathan Zaccaï, le téléfilm sera diffusé le mercredi 17 avril à 21h10.

27/03/2024, 10:57

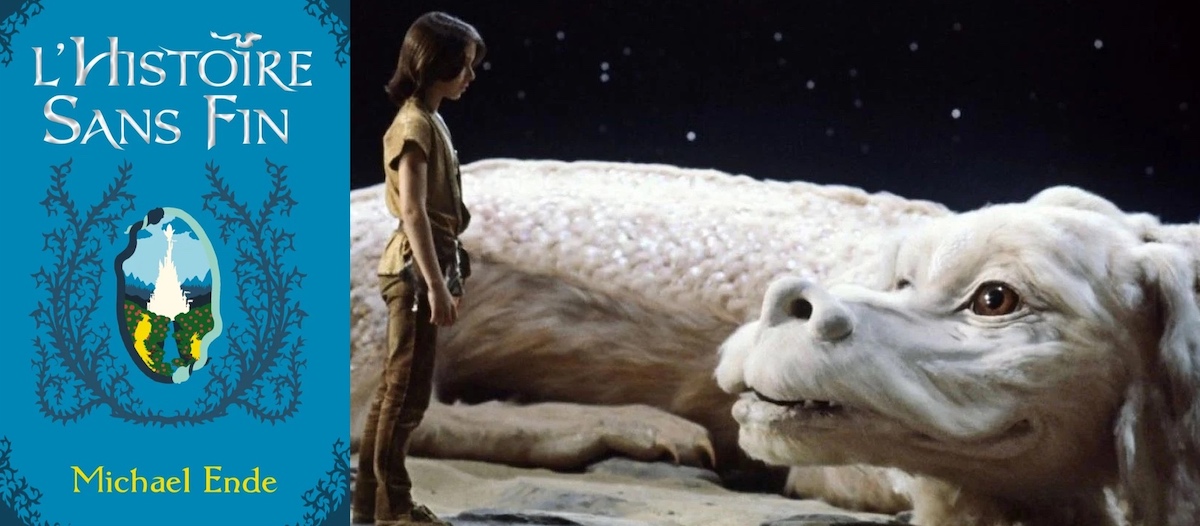

L'histoire sans fin, film et roman cultes, à nouveau adapté au cinéma

Quarante ans après la sortie du film L'histoire sans fin (1984), adaptation culte du livre éponyme de Michael Ende (trad. Dominique Autrand), la société de production See-Saw Films a annoncé avoir racheté les droits du roman en vue d'une nouvelle transposition sur grand écran de ce récit jeunesse fantastique.

26/03/2024, 16:15

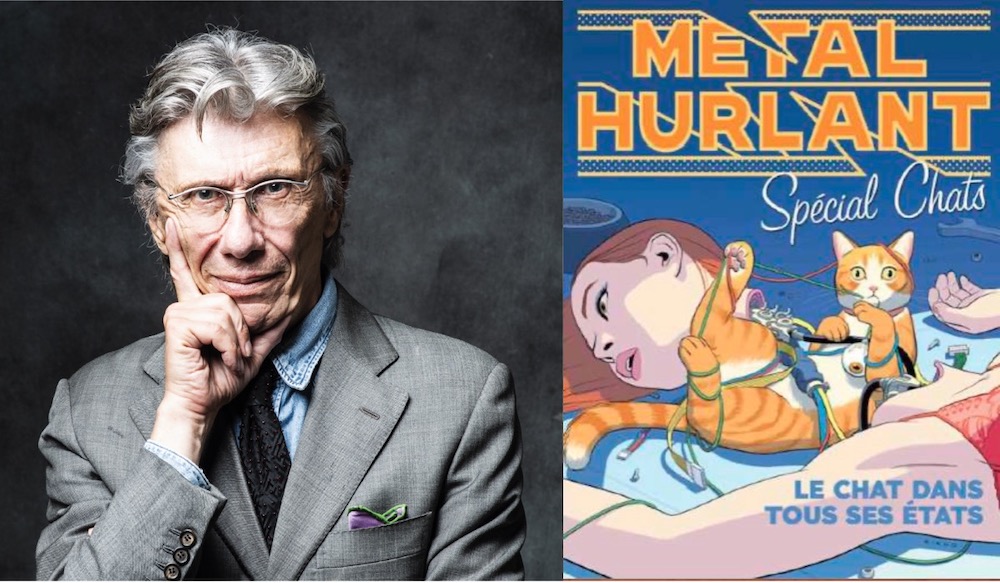

Pour les (presque) 50 ans de Métal Hurlant, Jean-Pierre Dionnet et les chats

En 2021 revenait le magazine culte de la SF, Métal Hurlant, après un premier essai infructueux au début des années 2000. Un projet aujourd'hui porté par le patron des éditions Humanoïdes Associés, Fabrice Giger, et le directeur de la rédaction Jerry Frissen. Ces derniers ont convaincu le rédacteur en chef historique, Jean-Pierre Dionnet, de reprendre les rênes, à l'occasion des (presque) 50 ans de l'illustré, pour un numéro hors série spécial, consacré à l'animal totem de l'époque, le Chat. En librairie le 25 avril de l'an « 2924 ».

26/03/2024, 16:09

Séries : Lucky Luke, Édouard Philippe ou Olivier Norek sur France Télé

Du 15 au 22 mars dernier, s'est tenue à Lille l'édition 2024 de SériesMania, qui a révélé ses lauréats 2024. Aucune des créations France Télévisions présentées à l'occasion du festival ne figure parmi les récompensés. Plusieurs projets seront néanmoins prochainement diffusés, dont une large part d'adaptations de livres, du thriller d'un ancien Premier ministre au retour du Lonesome Cowboy...

25/03/2024, 13:05

La Grande Librairie : ce que “partir” veut dire

Partir, à la fin de sa vie, à l’heure des débats sur la loi « grand âge » et sur le « bien vieillir ». Partir, c est aussi s’aventurer, s’en aller vers d’autres cultures, d’autres contrées. Partir, enfin, ce peut être tout simplement marcher, avancer, vivre sur ses deux pieds l’aventure de l’humanité !

24/03/2024, 10:05

Hannelore Cayre, Chloé Delchini et Emily Brontë sur France Culture

Dans ses grilles de programme, France Culture s'assure de réserver une place de choix à la littérature et aux écrits en général. Fiction, essai, bande dessinée et illustration sont représentés. Au cours de la semaine du lundi 25 au dimanche 31 mars, les invités seront nombreux...

22/03/2024, 15:56

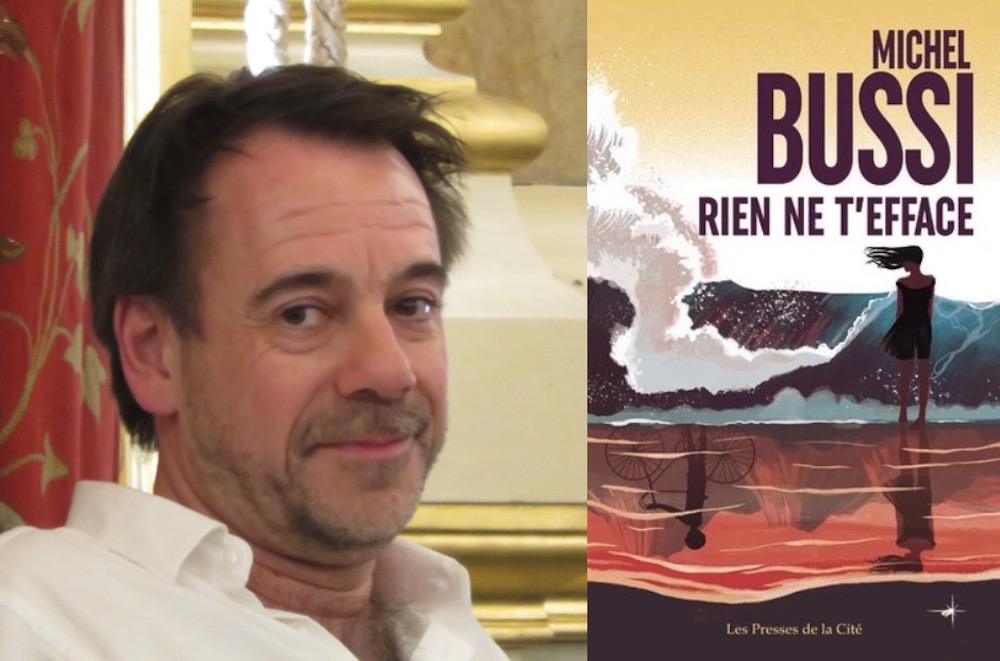

Le Puy-de-Dôme, décor d'une nouvelle adaptation de Michel Bussi

Rien ne t'efface, polar signé Michel Bussi, sera prochainement adapté en série télévisée. L'auteur, qui fait partie des meilleurs vendeurs de livres en France, verra pour la cinquième fois une de ses histoires policières sur le petit écran.

21/03/2024, 12:52

La naissance de George Sand en mini-série, sur France TV

Avant d'être George Sand, elle fut Amantine Aurore Lucile Dupin de Francueil. Une mini-série en quatre épisodes reviendra sur les jeunes années de l'autrice d'Indiana et La Petite Fadette, pour France Télévisions. Avec, pour incarner Sand, Nine d’Urso en vedette.

21/03/2024, 12:45

Captain America et Black Panther dans un Paris occupé

Les studios Marvel réduisent la voilure au cinéma, mais les autres médias restent d'actualité : à l'occasion de l'événement State of Unreal, Skydance New Media et Marvel ont diffusé de nouvelles images du jeu Marvel 1943 : Rise of Hydra...

21/03/2024, 10:49

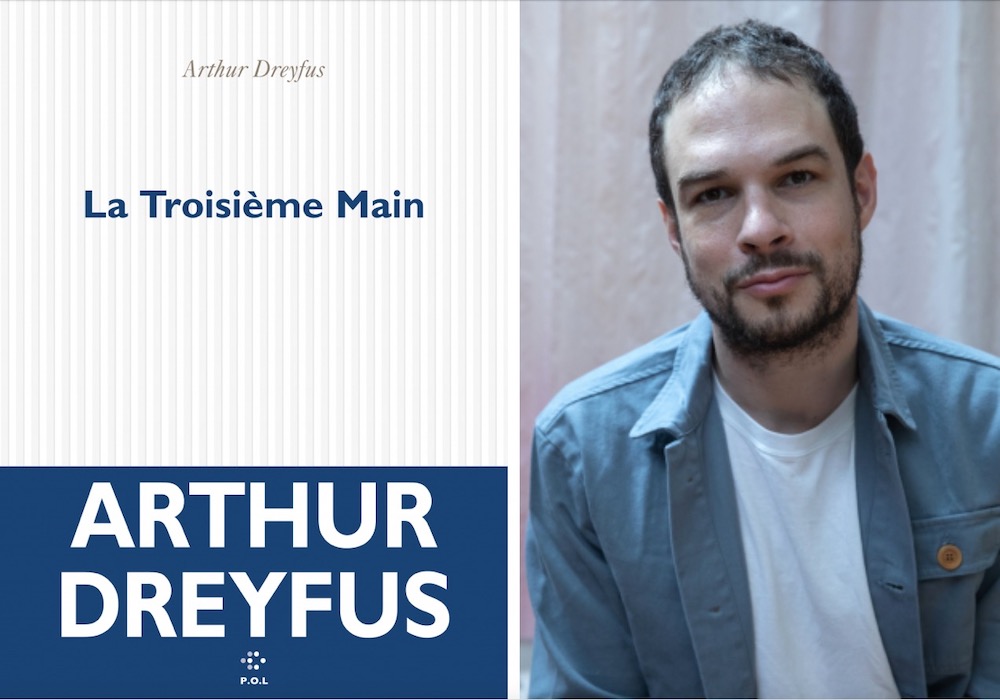

La Troisième Main d’Arthur Dreyfus adapté au cinéma par Hazanavicius

« Michel Hazanavicius a acheté les droits du livre d’Arthur Dreyfus La Troisième Main, publié en septembre 2023 aux éditions P.O.L », révèle la maison d'édition sur sa page X. Le réalisateur adapte de nouveau un roman, après la série d'espionnage née à la fin des années 40 OSS 117, l'adaptation du récit Un an après d'Anne Wiazemsky, Le Redoutable, et, pour fin 2024 normalement, La Plus Précieuse des marchandises de Jean-Claude Grumberg. Sauf s'il décide de porter la seule casquette de producteur pour cette fois.

20/03/2024, 11:51

Une fête schtroumpftastique : un party game tiré de l'oeuvre de Peyo

L'éditeur Microids, familier des adaptations vidéoludiques d'œuvres du 9e art (Asterix & Obélix, Tintin...) a annoncé la sortie de Les Schtroumpfs — Village Party pour le 6 juin prochain. Ce party game — composé de mini-jeux à plusieurs — sera disponible sur plusieurs plateformes, de la Switch au PC, en passant par la PS4, la PS5, la Xbox One et les Xbox Series X|S.

19/03/2024, 09:02

La Grande Librairie, sage comme une image

Cette semaine, quelques leçons de sagesse dans La Grande Librairie ! Et si la littérature nous montrait des chemins ? Aujourd’hui, plus que jamais, n’en a-t-on pas besoin ? Et qui mieux que cinq écrivains - romanciers, poètes ou philosophes - pour nous guider dans les méandres de la pensée ?

18/03/2024, 11:51

Sur France Culture, Christine Angot et Gabriel García Márquez

La programmation littéraire de la semaine prochaine sur France Culture conserve sa diversité habituelle, mélangeant nouveautés, œuvres classiques, romans, essais, débats et interviews. Voici les prochaines émissions de la station de radio publique.

18/03/2024, 11:25

Deux romans d'apprentissage féminins dans Au bonheur des livres

Les invitées de Guillaume Durand cette semaine dans Au bonheur des livres ont des opinions divergentes sur l'utilisation du mot « écrivain » ou « écrivaine », mais elles écrivent toutes deux de puissants textes sur les femmes, leur condition et leur destin.

13/03/2024, 16:40

Commenter cet article